Una decisión de un juez de Cartagena abrió un debate sobre el uso de inteligencia artificial en la resolución de problemas jurídicos en Colombia, pues el togado acudió a la popular herramienta ChatGPT para hacerle preguntas que luego incluyó en una parte de la sustentación de una sentencia de tutela.

La tutela la había presentado la familia de un menor de edad con trastorno del espectro autista contra una EPS, a la que le pedía exonerarlos del cobro de la cuota moderadora de citas médicos y tratamientos, así como transporte desde la casa hasta los sitios de las terapias, porque los padres del menor argumentaban no tener los recursos económicos para cubrir esos gastos.

Usando ChatGPT, el Juzgado Primero Laboral de Cartagena terminó por darles la razón y confirmó una decisión de primera instancia que ya le había ordenado a la EPS asumir esos gastos.

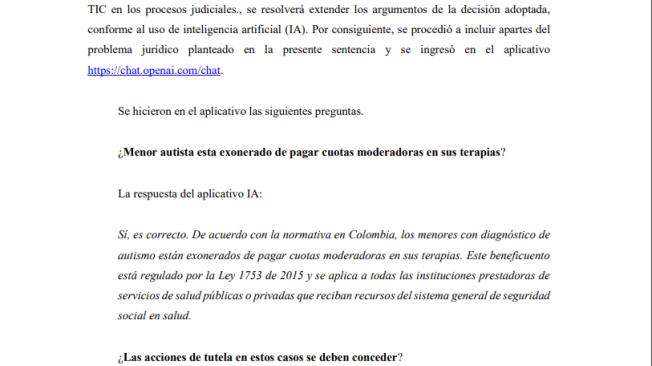

“El Despacho resolverá adicionar los fundamentos de la resolución del caso a partir de la construcción de textos realizada en el aplicativo IA https://chat.openai.com/chat a título de iniciativa que permita dar celeridad a la resolución de los asuntos de tutela”, se señala al respecto.

El juez Manuel Padilla García, que tomó la decisión, añadió: “El propósito de incluir estos textos producto de la IA no es en manera alguna reemplazar la decisión del Juez. Lo que realmente buscamos es optimizar los tiempos empleados en redacción de sentencias, previa corroboración de la información suministrada por IA”.

¿Qué le preguntó a ChatGPT?

En este caso, el juez Padilla usó la herramienta de inteligencia artificial para preguntarle algunas cosas como si un menor de edad autista está exonerado de pagar cuotas moderadoras en sus terapias, si exigir en esos casos la cuota moderadora es una barrera para acceder al servicio, si la Corte Constitucional ha tomado decisiones favorables en casos similares, y en qué casos deben concederse tutelas.

El juez luego puso las respuestas que obtuvo del aplicativo. Por ejemplo, frente a la pregunta “¿Menor autista está exonerado de pagar cuotas moderadoras en sus terapias?”, la herramienta contestó: “Sí, es correcto. De acuerdo con la normativa en Colombia, los menores con diagnóstico de autismo están exonerados de pagar cuotas moderadoras en sus terapias. Este beneficuento (sic) está regulado por la Ley 1753 de 2015 y se aplica a todas las instituciones prestadoras de servicios de salud públicas o privadas que reciban recursos del sistema general de seguridad social en salud”.

Críticas al uso de la herramienta

Me dejó muy preocupado la sentencia del Juzgado de Circuito Laboral #1 de Cartagena que usó respuestas de #ChatGPT para motivar una decisión de segunda instancia de una tutela relacionada con el derecho fundamental a la salud.

— Juan David Gutiérrez (@JuanDGut) January 31, 2023

Explico por qué me preocupa en este hilo: pic.twitter.com/5cLJaEJatz

El abogado Juan David Gutiérrez analizó esta sentencia y cuestionó el uso que el juez hizo de ChatGPT en sus argumentos de decisión pues dijo que la inteligencia artificial tiene fallas de verificación y puede arrojar respuestas imprecisas, incluso, diferentes frente a una misma pregunta.

De hecho, el profesor asociado de la Universidad del Rosario le hizo las mismas preguntas que el juez al aplicativo y sus respuestas fueron ligeramente diferentes.

“Mi punto no es que no se pueda usar IA generativa, como #ChatGPT, para realizar actividades asociadas con escritura, pero ciertamente no es responsable ni ético usar #ChatGPT como pretendió el Juez de la sentencia en cuestión”, expuso el profesor.

Incluso, él le pidió a la herramienta las sentencias de la Corte Constitucional a las que se refirió para decir que sí había jurisprudencia en ese sentido, la aplicación no solo no dijo cuáles eran esas sentencias sino que al pedirle ejemplos, se los inventó.

“Es prioritario que la Rama Judicial cuente con políticas y reglas claras sobre qué usos de IA son adecuados y en qué contextos. Además debe capacitar a los jueces para que usen las herramientas de manera informada, ética y responsable”, concluyó Gutiérrez.

Fuentes: eltiempo.com

“ChatGPT tiende a arrojar resultados incorrectos, imprecisos, y falsos. No distingue realidad de ficción. De hecho la herramienta así lo advierte cada vez que uno ingresa para hacer consultas”, sostuvo en un hilo de Twitter.